Éliminer les fausses données sur Google Analytics.

La plupart des spécialistes en référencement web aiment voir et analyser les données de trafic d’un site web. C’est aussi le cas pour un propriétaire de site web qui désire voir à quel niveau son site web est vu par sa clientèle potentielle recherchant de l’information sur le web. Le meilleur outil d’analyse de trafic web présent est, bien sûr, Google Analytics. On y trouve toutes les données nécessaires pour comprendre la démographie du trafic d’un site web et y voir la rentabilité que celle-ci peut avoir sur une entreprise.

De nos jours, beaucoup de robots se promènent sur le web pour y inspecter les sites web et les indexer à leurs données. Il n’y a pas beaucoup de personnes qui connaissent la raison exacte pour laquelle ils naviguent le web, mais ils le font quand même et cela peut nuire à la compréhension des données offertes par Google Analytics. Cet outil d’analyse n’est pas infaillible et même si les robots naviguant le web ne sont pas de vraies personnes, ils sont quand même interprétés comme des navigateurs qui visitent le site web que l’on analyse. Ces robots viennent trafiquer nos données de trafic et ne devraient pas se trouver dans vos données d’analyse par faute de les truquer faussement.

Cet article a pour but de montrer à tous comment éliminer les fausses données de Google Analytics et ainsi ne plus avoir de mauvaises informations lors que l’on analyse le trafic d’un site web.

Identifier les robots

Du jour au lendemain, de nouveaux robots apparaissent dans vos données de navigation Google Analytics et ceux-ci gâchent vos résultats. Les démasquer est la première étape pour les éliminer de nos données de trafic web.

Comme il est mentionné plus haut, Google Analytics est un outil d’analyse de trafic qui permet de voir toutes les données possibles de navigation sur un site web. L’utiliser pour démasquer l’espion dans nos troupes est donc très pertinent.

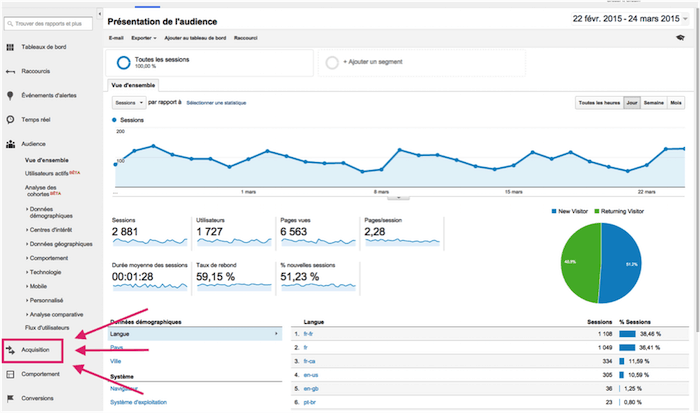

Pour ce faire, il faudra accéder au compte Google Analytics et entrez dans la campagne que l’on veut corriger. Une page comme la suivante devrait apparaître lors que l’on rentre dans le compte désiré :

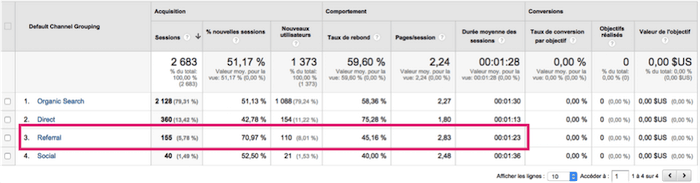

Pour cibler précisément les robots indésirables, il faut aller voir les données segmentées par type de canaux d’acquisition. Pour ce faire, aller dans Acquisition -> Présentation -> Tout le trafic -> Canaux.

Vous y verrez un tableau comme celui-ci :

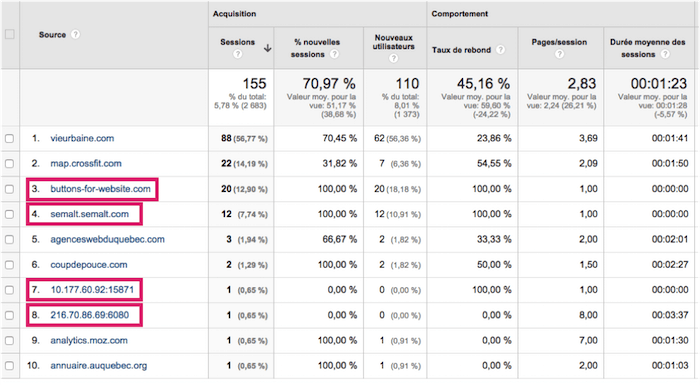

Pour voir si un espion se cache parmi les sites web référents, vous devrez faire l’analyse de ceux-ci un par un. Pour sa part, le site web analysé dans le tableau précédent possède 2 sites web et 2 adresses IP, encadrés en rouge, qui amènent du « faux trafic web ». Les autres sites web référents sont soit des annuaires, des sites de coupons-rabais, des articles ou des publicités en ligne qui envoient de vraies personnes sur le site web que l’on veut promouvoir. Ces derniers sont tous à conserver dans les données d’analyse, car ils apportent une vraie valeur à celles-ci.

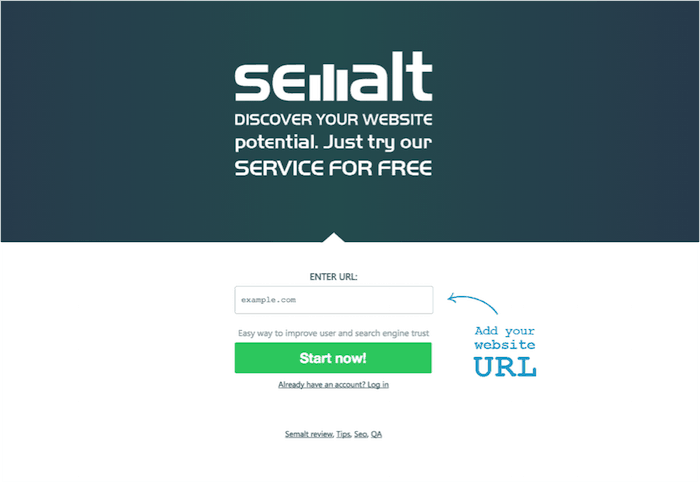

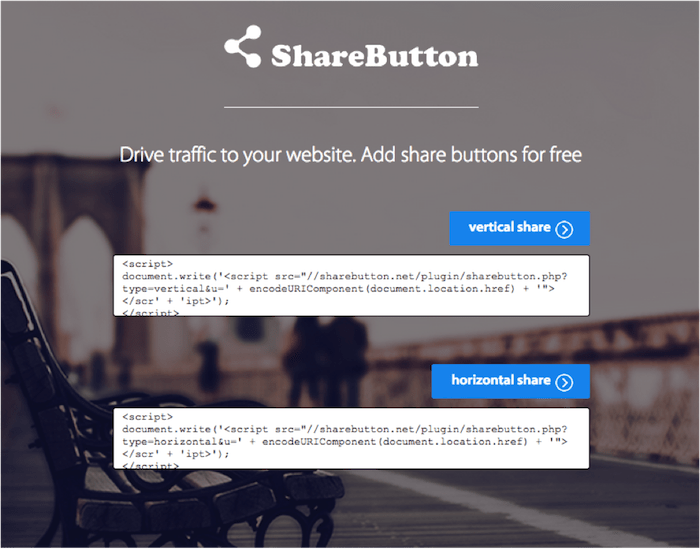

Allons voir à quoi ressemble un site web que l’on ne veut pas dans nos données de trafic, en observant la page d’accueil de semalt(.)com, où l’on est redirigé lorsque l’on tape semalt(.)semalt(.)com, et la page d’accueil de buttons-for-website(.)com où l’on est redirigé lors que l’on visite le site web sharbutton(.)net.

En arrivant sur ces deux sites web référents, on peut constater dès l’arrivée que ceux-ci n’offrent pas une réelle valeur au trafic de votre site web. Il n’est pas possible d’y voir des sites web qui pourraient être intéressants à visiter pour s’informer sur un sujet. Ils proposent également plus de visites sur les sites web s’y inscrivant, sans toutefois vous proposer d’aller voir des sites web qui si sont inscrits. D’où peut bien provenir le nouveau trafic proposé s’il n’est pas possible de voir un site web externe à Semalt ou SharButton lors que l’on navigue sur ceux-ci?

Ces sites web augmenteront réellement le trafic d’un site web s’y inscrivant, mais à tort, car ces visites sont faites par des robots qui n’achèteront pas un produit, ne commenteront pas sur des articles de blogue et ne chercheront pas à contacter une entreprise pour ses services. Combien valent des visites de site web qui ne sont pas possibles à convertir? RIEN. Il ne faut absolument pas s’y inscrire par intérêt de ne pas fausser ses données d’analyse.

Filtrer les informations indésirables des sites référents

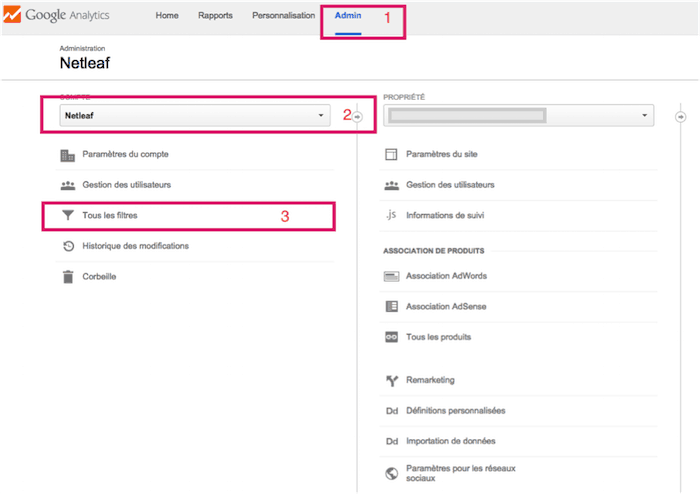

- Allez dans la section « Admin » de votre compte;

- Sélectionnez le compte pour lequel vous voulez faire les modifications (dans ce cas-ci, « Netleaf »)

- Cliquez sur le lien « Tous les filtres ».

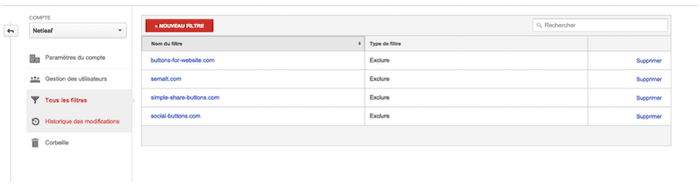

Un tableau semble au suivant apparaîtra :

Il faudra cliquer sur le bouton rouge « NOUVEAU FILTRE » pour créer un filtre qui permettra d’éliminer les sites web référents inutiles. Il devrait apparaître une page comme la suivante.

Pour créer un filtre qui éliminera les fausses données de votre compte Analytics, suivez les étapes suivantes :

- Nommez votre filtre;

- Choisissez « Sélectionnez un type de filtre » et sélectionnez « Exclure »;

- Sélectionnez « Sélectionnez la source ou la destination » et choisissez l’option « Trafic à partir du domaine de FAI » si le robot naviguant sur le site est à partir d’un nom de domaine ou « Trafic provenant des adresses IP » si le robot provient d’une adresse IP précise. Lors que vous aurez sélectionné une de ces options, vous pourrez entrer l’adresse URL ou IP du robot à exclure des données d’analyse;

- Sélectionnez « Sélectionner l’expression » et choisissez « contenant » pour inclure toutes les expressions possibles provenant de cette URL ou de cette adresse IP ;

- La dernière étape, mais non la moindre, sera de sélectionner les campagnes pour lesquelles vous voulez appliquer le filtre.

- Toutes ces étapes sont à refaire pour éliminer toutes les URL ou adresses IP indésirables dans les différentes campagnes de Google Analytics.

Conclusion

Categories

- Blogue (68)

- Design web (7)

- Recherches vocales (2)

- Référencement local (11)

- Référencement naturel (41)

- Référencement payant (3)

- Uncategorized (2)